El sitemap en Shopify: Más que un simple archivo XML

El sitemap en Shopify es una herramienta de diagnóstico útil más allá de su envío rutinario a motores de búsqueda. En catálogos grandes, este archivo permite ver de un vistazo qué páginas están expuestas al rastreador y detectar URLs basura, paginación indexada incorrectamente, duplicados por colecciones o filtros, y rutas que devuelven errores 404 o soft 404. Usarlo como punto de partida acelera las decisiones sobre qué indexar y qué bloquear mediante noindex, etiquetas canonical o redirecciones.

Por qué el sitemap en Shopify importa

Revisar el sitemap revela la estructura real que el comercio comunica a los buscadores. En Shopify, suele estar disponible en la raíz del dominio como sitemap.xml (que actúa como un sitemap_index.xml) y referencia sitemaps específicos por tipo de contenido. Esto facilita priorizar páginas con mayor potencial de conversión y encontrar patrones técnicos que consumen crawl budget ineficientemente. Para comprobar su ubicación y formato, puedes consultar guías públicas como la de Seomator.

Conceptos técnicos clave

Antes de auditar, es fundamental distinguir tres elementos que trabajan en conjunto:

- Sitemap: Archivo XML que lista URLs y ayuda a los buscadores a descubrir cambios y nuevas páginas.

- Robots.txt: Archivo de reglas que indica a los rastreadores a qué secciones no acceder y protege recursos que no deben ser rastreados (como el carrito o el checkout).

- Etiqueta Canonical: Instrucción en la cabecera HTML que señala la versión preferida de un contenido duplicado, evitando la canibalización de palabras clave.

Qué esperar de la auditoría

La auditoría parte del sitemap para identificar bloques de URLs a limpiar y priorizar acciones por impacto de negocio. En las siguientes secciones desglosaremos pasos concretos para detectar URLs basura, aplicar noindex en plantillas Liquid, implementar canonicals correctos y configurar redirecciones en Shopify.

Anatomía del sitemap de Shopify y sus limitaciones

El sitemap de Shopify es la referencia principal que usan los motores de búsqueda para descubrir las páginas de tu catálogo. Entender su estructura y sus limitaciones es clave antes de empezar, ya que en esta plataforma el sitemap se genera automáticamente y no se puede editar de forma manual (al menos, no el archivo XML en sí).

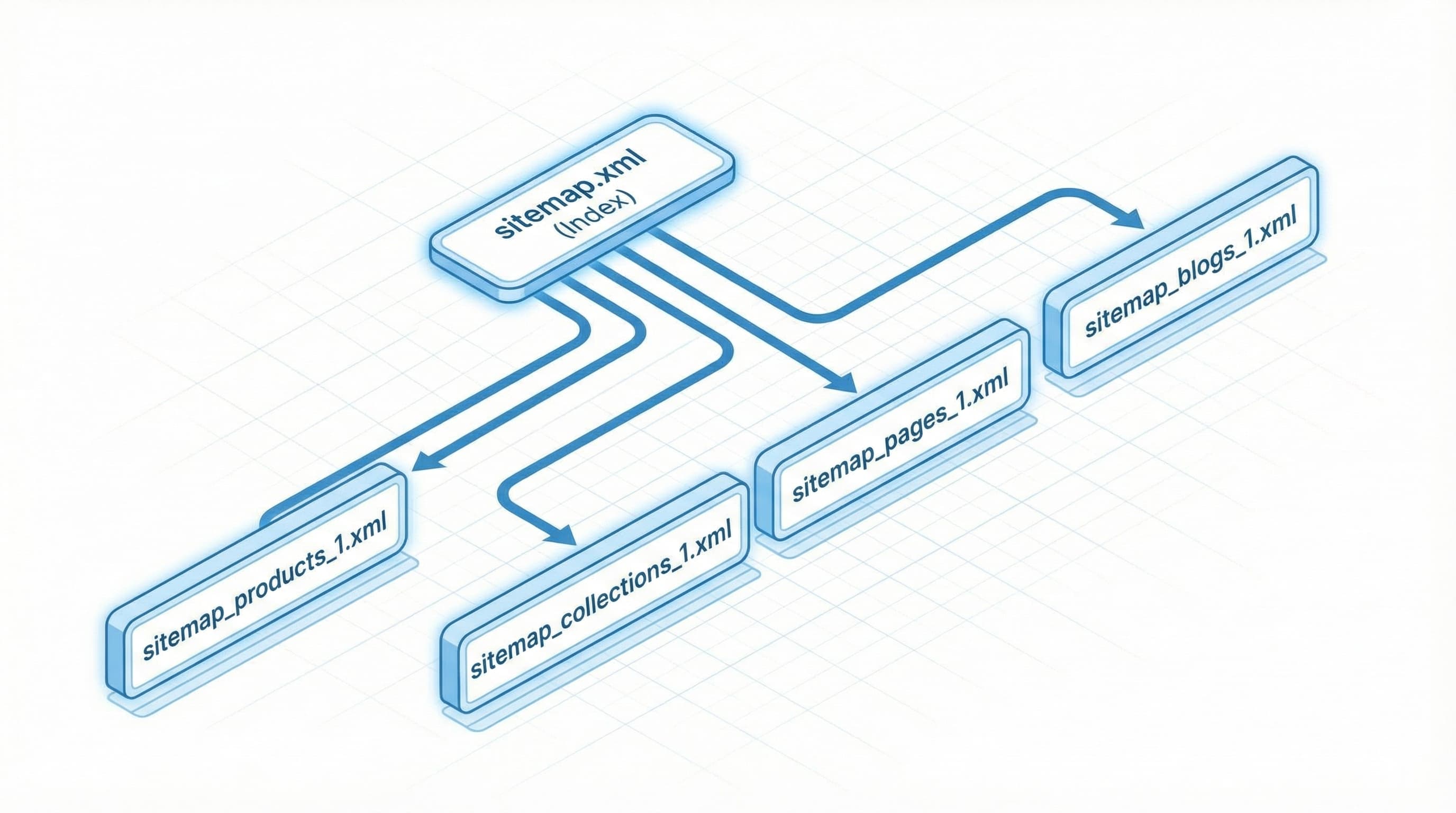

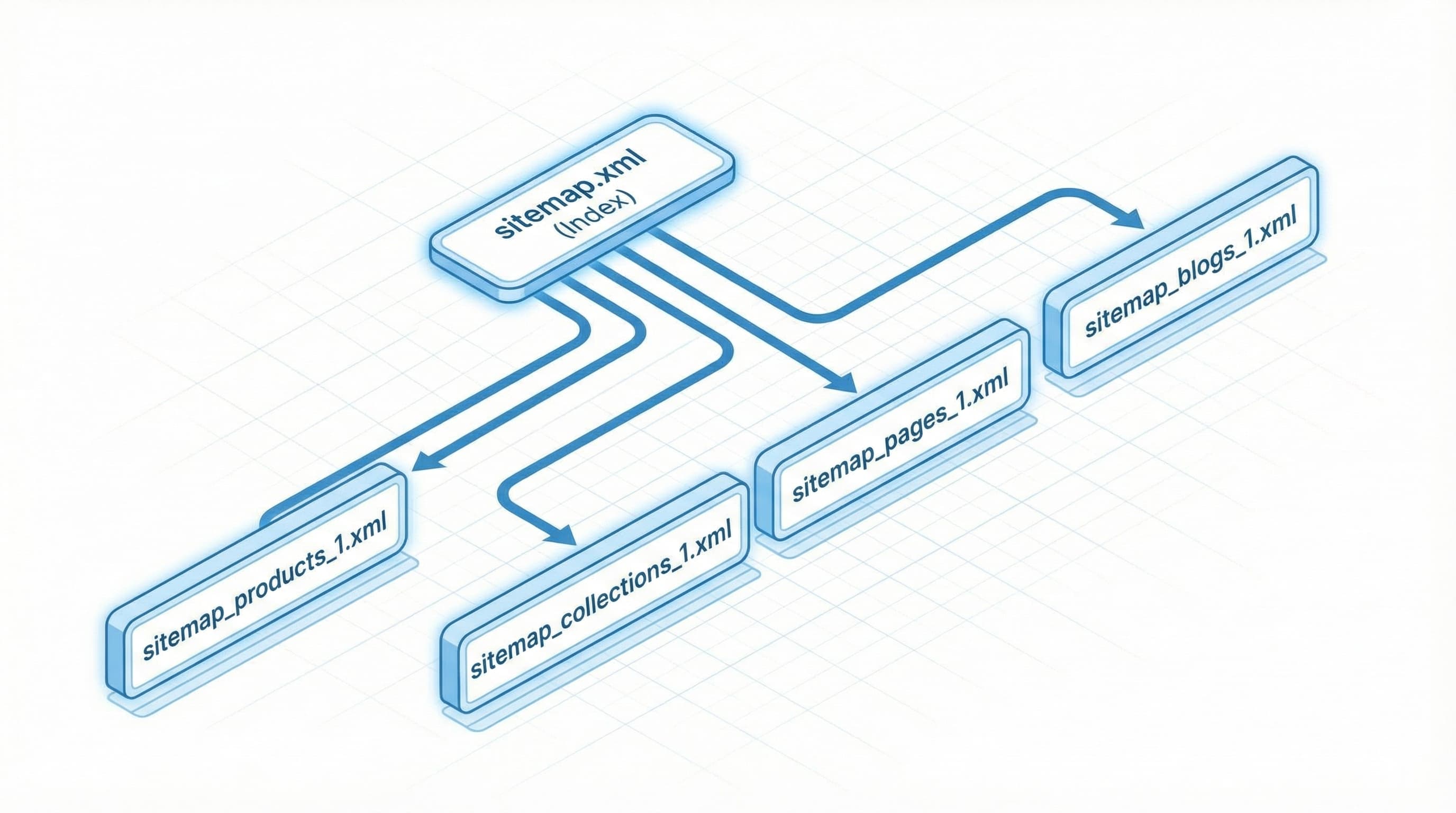

Estructura general: El Sitemap Index

El archivo sitemap.xml actúa como un índice que agrupa "sitemaps hijos" por tipo de recurso para facilitar el rastreo.

Descarga el sitemap index y abre los sitemaps hijos (products, collections, pages, blogs) para inspeccionar patrones repetidos y el volumen de URLs. La especificación estándar de sitemaps permite hasta 50.000 URLs por archivo y 10 megabytes sin comprimir; para más detalles técnicos puedes consultar la guía de Google para desarrolladores.

Ejemplo de estructura:

Un sitemap index típico contiene referencias a sitemap_products_1.xml, sitemap_collections_1.xml y sitemap_pages_1.xml. Si products_1 excede el límite, Shopify genera automáticamente sitemap_products_2.xml.

Error típico:

Asumir que todos los sitemaps hijos tienen la misma calidad. A menudo, el sitemap de productos está limpio, mientras que el de colecciones puede estar contaminado con cientos de variantes generadas por apps de terceros.

Qué controla el usuario y qué no

Existe confusión sobre qué partes del sitemap puede modificar directamente un merchant o un SEO.

En Shopify, el archivo se actualiza automáticamente basándose en el catálogo público. No puedes editar el XML directamente. Sin embargo, controlas indirectamente su contenido mediante:

- La visibilidad de productos, colecciones y páginas (publicado/oculto).

- La implementación de canonicals y

noindex a través de la edición de plantillas (theme.liquid).

- El uso de Metafields: campos para almacenar datos personalizados que permiten automatizar reglas de SEO (por ejemplo, "indexable: false") por producto o colección.

Ejemplo práctico:

Configurar una plantilla de colección con una etiqueta noindex evitará que sus URLs se indexen, aunque sigan existiendo en la tienda. Eventualmente, Google dejará de mostrarlas, aunque Shopify las mantenga en el sitemap por un tiempo hasta que se despubliquen.

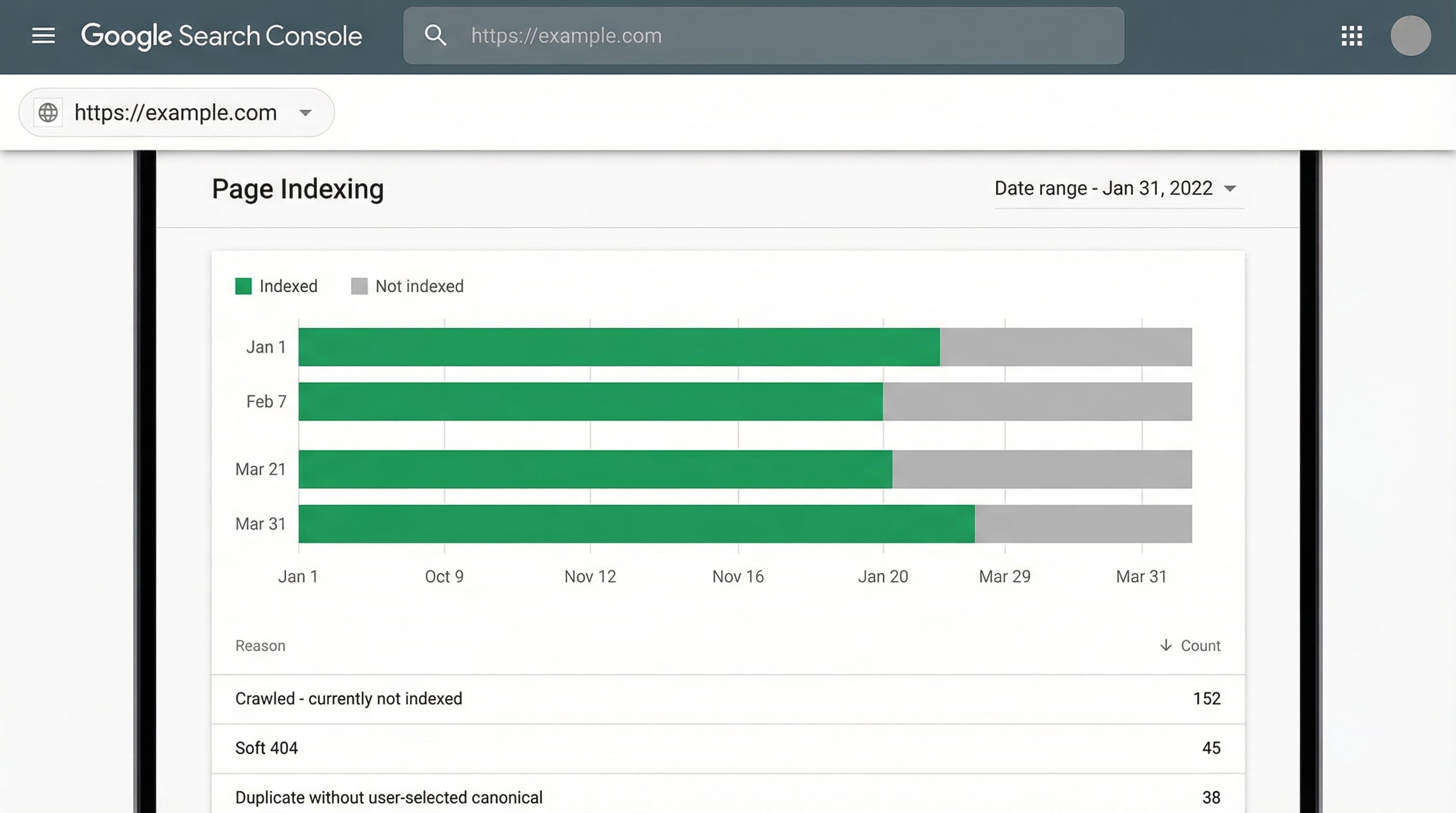

Señales de contaminación del sitemap

Detectar "ruido" en el archivo ayuda a priorizar acciones correctoras. Las señales comunes incluyen:

- 404s listadas: URLs que ya no existen pero siguen en el XML.

- Soft 404s: Páginas de producto vacías o con stock agotado que no redirigen.

- Duplicados: URLs generadas por filtros de colección o parámetros de seguimiento.

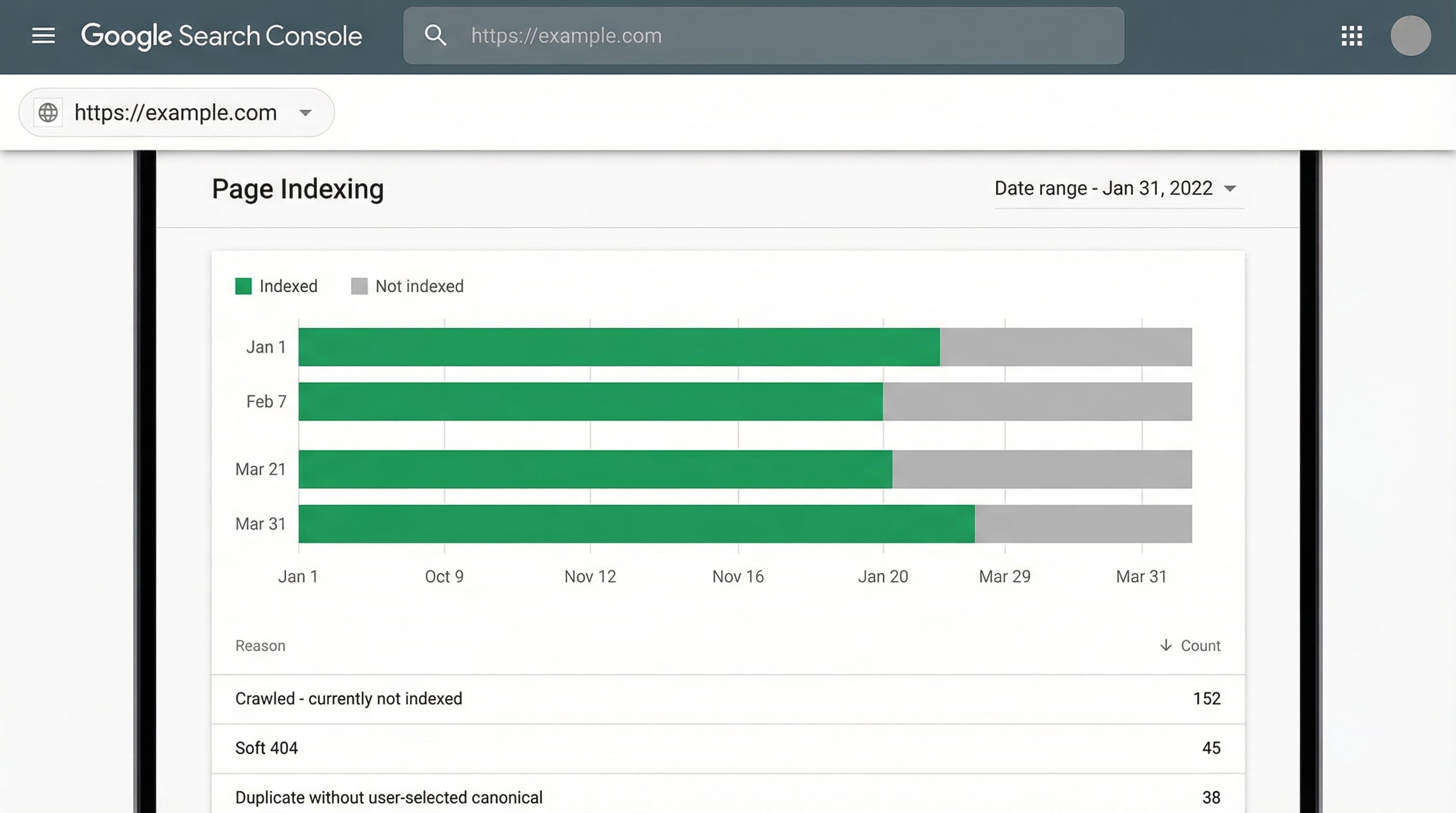

Cruza los sitemaps con los datos de cobertura de Google Search Console y con los logs de rastreo para medir la tasa de error real. Prioriza limpiar los sitemaps hijos que generen más errores y contengan URLs sin tráfico orgánico.

Lectura rápida para auditar sitemaps hijos

Una revisión técnica inicial acelera la auditoría. Genera dos listas exportables: el sitemap versus el listado real de productos exportado de Shopify y calcula la diferencia. Inspecciona cambios recientes de plantillas y reglas de visibilidad.

Fuentes adicionales:

La documentación de Shopify sobre sitemaps y las pautas de Google Search Central son referencia obligada:

Auditoría del sitemap paso a paso: Detectando ineficiencias

Esta metodología paso a paso muestra cómo usar el sitemap como herramienta operativa para detectar ineficiencias, localizar URLs huérfanas y priorizar la indexación.

TL;DR: Cruza el sitemap generado por Shopify con el informe de cobertura de Search Console y un rastreo completo (crawling). Identifica entradas en el sitemap que devuelvan 404 o redirecciones, vistas filtradas sin rel="canonical" y páginas sin enlaces internos.

1. Identificar 404s y Soft 404s

Las páginas 404 y soft 404 consumen crawl budget y envían señales negativas de calidad.

Cómo abordarlo:

Cruza el informe de cobertura de Search Console con un rastreo propio usando un crawler (como Screaming Frog o similar). Filtra por códigos de estado 404 y por páginas con contenido mínimo ("Producto no encontrado" pero con código 200) que Google clasifica como soft 404.

Ejemplo:

Un producto aparece en sitemap_products_1.xml pero devuelve un error 404 al visitarlo.

- Acción: Crea una redirección 301 hacia el producto equivalente o a la colección padre.

2. Detectar contenido duplicado por colecciones y filtros

Los parámetros y filtros generan múltiples URLs con contenido idéntico o muy similar, diluyendo la autoridad de la página.

Cómo abordarlo:

Rastrea URLs de colecciones con parámetros (?sort_by=, ?filter.v=) y comprueba la etiqueta rel="canonical". Esta etiqueta debe indicar la URL preferida para concentrar las señales de ranking. En Shopify, asegúrate de que el tema devuelve el canonical correcto o aplica noindex a las vistas filtradas que no aportan valor SEO.

Ejemplo:

Una colección con parámetro de color (/collections/zapatos?color=rojo) genera varias variantes.

- Acción: Todas deben canonicalizar a la URL principal

/collections/zapatos si no hay un cambio sustancial de contenido, o bien ser gestionadas como páginas únicas si hay demanda de búsqueda específica para "zapatos rojos".

3. Encontrar URLs huérfanas y priorizar indexación

Las URLs sin enlaces internos son difíciles de rastrear y raramente reciben tráfico orgánico, incluso si están en el sitemap.

Cómo abordarlo:

Genera el mapa de enlaces internos con tu rastreador y crúzalo con el sitemap. Prioriza las correcciones por impacto comercial: revisa páginas de alto margen que estén huérfanas y añade enlaces desde el menú, colecciones destacadas o artículos del blog.

Error típico:

Intentar corregir todas las huérfanas por igual, en lugar de priorizar las que tienen potencial de ventas.

4. Acciones prácticas en Shopify

Las correcciones deben implementarse en la plataforma para cerrar el ciclo.

Cómo abordarlo:

- Noindex: Aplica meta tags vía

theme.liquid o apps de SEO para vistas filtradas irrelevantes.

- Redirecciones: Usa el panel de navegación de Shopify para crear 301s.

- Robots.txt: Edita este archivo (con precaución) para bloquear patrones de búsqueda interna o filtros masivos.

Limpieza y optimización: Acciones concretas en tu tienda

El sitemap es tu mapa de guerra. Enfoca esta sección en acciones aplicables desde el panel de Shopify para reducir ruido, priorizar indexación y optimizar el presupuesto de rastreo.

Revisar y aplicar noindex a URL basura

Eliminar páginas de baja calidad del índice evita que consuman recursos y debiliten la autoridad del dominio.

Cómo abordarlo:

Enumera URLs problemáticas detectadas en Search Console. Para grupos grandes de URLs, añade lógica condicional en la plantilla Liquid (theme.liquid o collection.liquid).

Ejemplo de código lógico (pseudocódigo):

{% if current_tags contains 'filtro-irrelevante' %}

<meta name="robots" content="noindex">

{% endif %}

Error típico:

Aplicar noindex a una colección entera sin validar primero si alguna de sus variantes (tags) está posicionando por palabras clave long-tail.

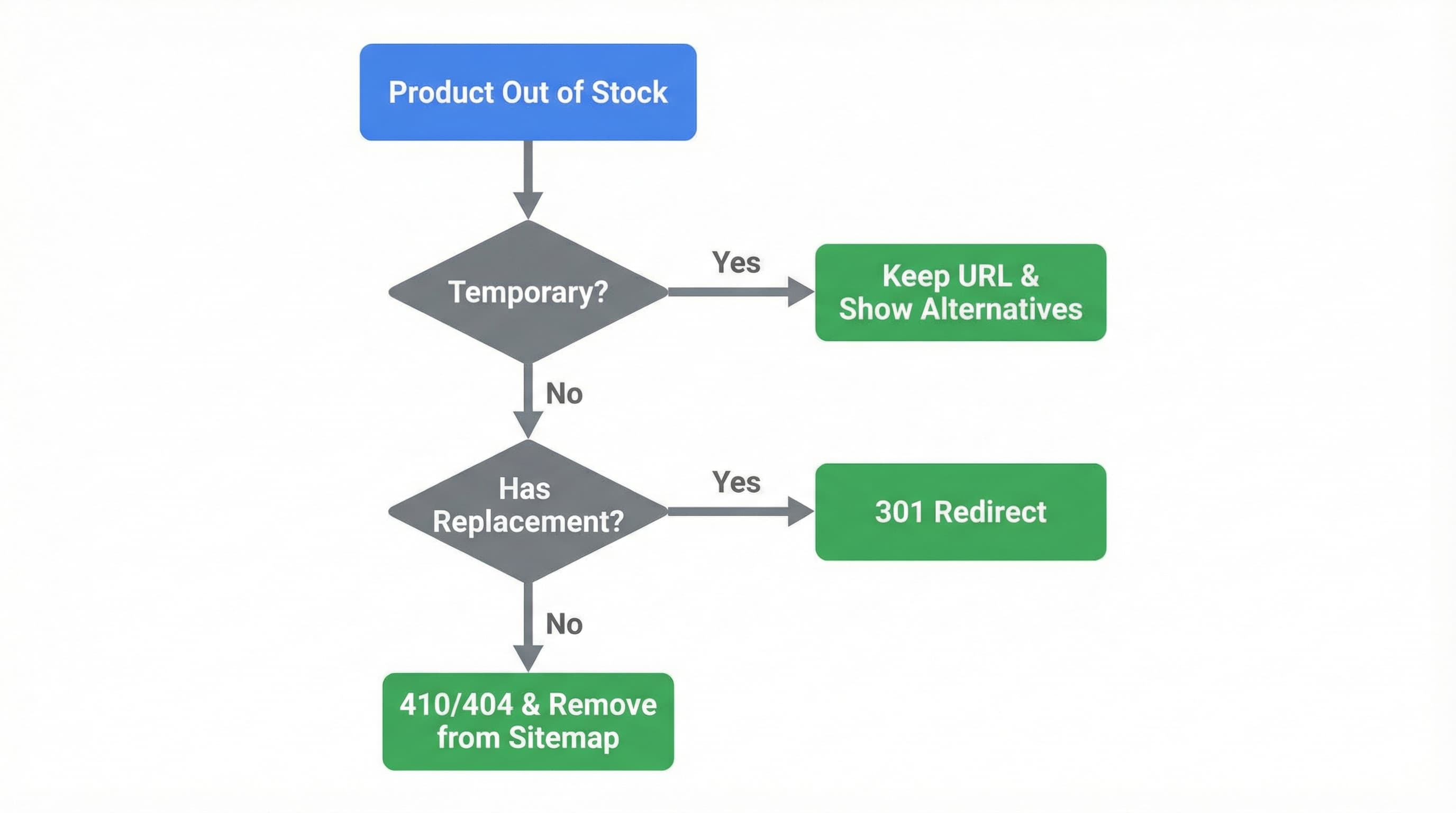

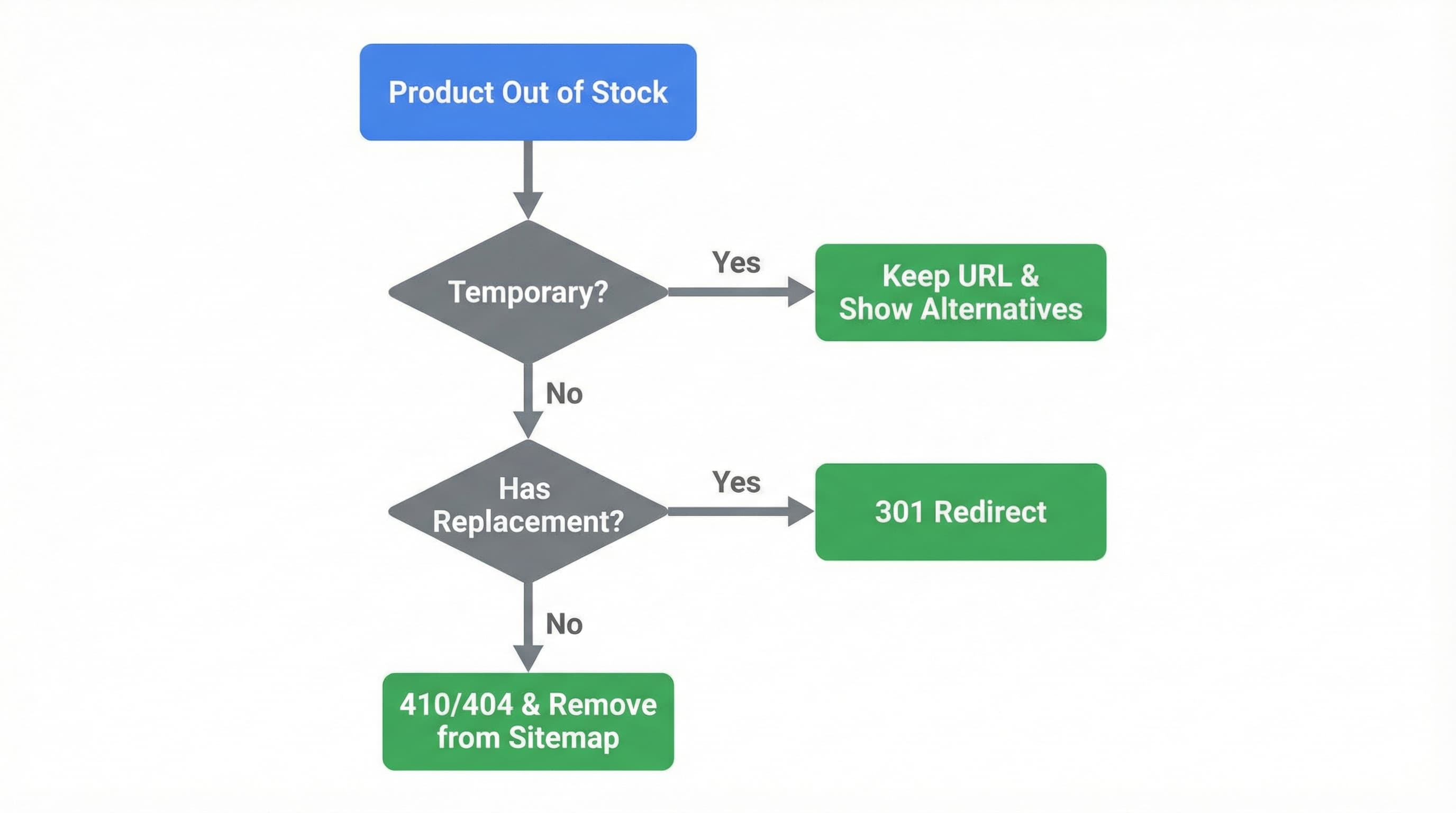

Gestionar productos agotados (Out of Stock)

Las páginas sin stock pueden seguir indexadas sin aportar conversión, aumentando el ruido en el sitemap y frustrando al usuario.

Estrategia:

Define una política clara:

- Temporal: Mantener la página con aviso de "Avísame cuando esté disponible" y productos alternativos.

- Permanente (Descatalogado): Redirección 301 a la colección más relevante o al producto sucesor.

- Sin reemplazo: Código 410 (Gone) o 404 customizado, eliminando la URL del sitemap (despublicando el producto en Shopify).

Acción en Shopify:

Crea redirecciones 301 desde el admin (Tienda online > Navegación > Redirecciones de URL) para productos discontinuados inmediatamente después de despublicarlos.

Canonicals y duplicados

Los duplicados fragmentan las señales de ranking. Es vital que Shopify apunte siempre a la versión "limpia" de la URL.

Cómo abordarlo:

Revisa la etiqueta rel="canonical" en el código fuente (Ver código fuente en el navegador). Ajusta las plantillas para que apunten a la URL canónica sin parámetros de rastreo (como fbclid o utm) ni variantes de colección (/collections/nombre/products/producto debería canonicalizar a /products/producto).

Redirecciones 301 y limpieza del sitemap

Las redirecciones 301 consolidan la autoridad de enlaces antiguos y reducen errores en el sitemap.

Cómo abordarlo:

Cuando elimines o muevas contenido, crea la redirección 301 de inmediato. Valida el sitemap posteriormente y fuérzalo a volver a procesarse en Search Console si los cambios son masivos.

Recursos:

Configuración avanzada: robots.txt y optimización del rastreo

En catálogos grandes, el sitemap sirve como punto de partida para detectar dónde se desperdicia crawl budget. Esta sección explica cómo editar el robots.txt en Shopify para aplicar reglas de bloqueo seguras.

Auditar entradas actuales

Identificar patrones de URLs que consumen rastreos sin aportar valor evita perder crédito de indexación en páginas útiles.

Cómo abordarlo:

Descarga tu sitemap y compáralo con el robots.txt público (tusite.com/robots.txt). Usa Search Console para ver qué URLs reciben más rastreos. Si detectas parámetros o rutas repetidas (como búsquedas internas q=), agrúpalos y bloquéalos.

Consulta la guía de Google sobre robots y crawl budget para validar tus criterios antes de bloquear nada.

Bloquear parámetros y filtros desde robots.txt

Las páginas de facetas y filtros infinitos son las mayores consumidoras de crawl budget en eCommerce.

Cómo abordarlo:

En el robots.txt de Shopify (editable vía robots.txt.liquid en el editor de temas), usa patrones Disallow que coincidan con las rutas problemáticas.

Ejemplo de regla:

Evitar el rastreo de ordenación en colecciones:

Disallow: /collections/*?sort_by=*

Precaución:

Prueba cada regla con la herramienta de inspección de URL o el probador de robots.txt en Search Console antes de subirla a producción. Una regla mal escrita puede desindexar todo el sitio.

Cambios seguros en Shopify

Shopify genera un robots.txt por defecto bastante sólido, pero personalizable.

Cómo abordarlo:

Revisa la ayuda oficial de Shopify sobre robots.txt. Implementa bloqueos solo para patrones claros de URLs basura. Para páginas individuales que quieres desindexar pero que Google siga rastreando (para pasar autoridad), usa noindex en la plantilla en lugar de bloquearlas en robots.txt.

Error típico:

Bloquear recursos .js o .css en robots.txt. Google necesita renderizar la página completa para entenderla; si bloqueas los estilos, puedes perjudicar tu ranking.

Automatización de la calidad del catálogo con ButterflAI

Una auditoría de sitemap exhaustiva suele revelar un problema de fondo: miles de URLs técnicamente indexables pero con contenido "thin" (descripciones vacías, duplicadas o pobres) que Google decide ignorar o clasificar como soft 404.

ButterflAI soluciona este cuello de botella generando y optimizando contenido de producto a escala. ButterflAI detecta los campos vacíos o de baja calidad en tu catálogo y utiliza IA contextual para generar títulos, descripciones y metafields únicos y optimizados para SEO. Esto transforma URLs "zombis" en páginas ricas en contenido que justifican su presencia en el sitemap y capturan tráfico cualificado, permitiendo a los equipos de eCommerce escalar su catálogo sin sacrificar la calidad técnica ni el crawl budget.